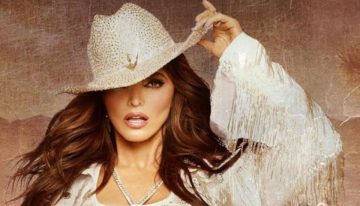

La casa está en silencio, excepto por el sonido de los teléfonos que no suenan. Martha Cumbero nos recibe en el salón de su hogar caraqueño, donde las paredes conservan aún los tonos de una vida que fue normal hace apenas semanas. Ella es … la esposa de Nicmer Evans, politólogo, intelectual de izquierda y director del medio web Punto de Corte. Su historia es la de una generación que creyó en la revolución, que la defendió, que la exportó a Europa. Y ahora, la historia de alguien que pagó el precio de haber cuestionado lo que ese movimiento se convirtió.

Evans fue chavista. Genuinamente chavista. Apoyó a Hugo Chávez hasta la muerte del comandante en 2013. Fue parte de ese círculo de intelectuales que tenía proximidad con el proyecto revolucionario, encargándose de difundir lo que vendían como un proceso transformador, incluso en las universidades europeas. Formó parte del Centro Miranda, esa institución caraqueña ubicada en el corazón del Parque Central que albergaba a intelectuales españoles como Pablo Iglesias y Juan Carlos Monedero. En esos salones y auditorios, se sesionaba sobre formación ideológica, sobre los círculos bolivarianos, sobre la construcción de una nueva sociedad. Evans era parte de ese proyecto. Era, en cierto sentido, un constructor de la narrativa revolucionaria.

Pero después de 2013, cuando Chávez murió, algo cambió. O quizás Evans simplemente vio lo que siempre estuvo ahí. Comenzó a hacer críticas al gobierno de Nicolás Maduro. Críticas públicas, documentadas, en su medio web Punto de Corte. Críticas que, en una Venezuela cada vez más autoritaria, se convirtieron en un acto de disidencia. El intelectual que había defendido la revolución se convirtió en su crítico. Y eso, en el Venezuela de Maduro, es un crimen.

El 13 de diciembre, la policía política vino a por él. Ahora, mientras nos sentamos en su salón, ella intenta explicar lo que significa esperar. «Es la segunda vez que se lo llevan», dice, con una voz que oscila entre la resignación y la rabia contenida. «La primera vez estuvo 51 días. Esta vez, tiene 25 días ». Ella hace cálculos mentales mientras habla, como si pudiera contar los días en su rostro.

La madrugada del 3 de enero, cuando Maduro fue capturado en una operación militar estadounidense, Martha sintió algo que no había sentido en semanas. «A pesar de no estar completamente de acuerdo con la forma en que ocurrió la captura, sentí una luz y una esperanza de cambio y de libertad para todos los que están presos en este momento», dice.

El jueves al mediodía, Jorge Rodríguez, presidente del Parlamento y hermano de la vicepresidenta Delcy, anunció desde la tribuna legislativa lo que el régimen se niega a llamar por su nombre: la liberación de presos políticos. En la jerga oficial, son simplemente «ciudadanos venezolanos y extranjeros» cuya excarcelación responde a un «gesto de paz unilateral». La precisión del lenguaje importa cuando se trata de negar lo obvio. Llamarlos presos políticos sería una admisión de lo que los organismos de derechos humanos documentan meticulosamente: crímenes de lesa humanidad.

Los que han salido

Para el viernes, cuando la euforia inicial comenzaba a sedimentarse, Foro Penal confirmó oficialmente los nombres de quiénes habían salido. Rocío San Miguel, activista de derechos humanos con nacionalidad hispano-venezolana, fue liberada tras permanecer detenida desde febrero de 2024. Enrique Márquez, quien fuera candidato presidencial, recuperó su libertad después de casi cinco meses de cautiverio que comenzaron el 28 de agosto. Biagio Pilieri, líder opositor, salió de las celdas donde había permanecido desde enero de 2025. Larry Osorio, activista de derechos humanos, fue excarcelado tras más de tres años y medio de encarcelamiento que se remontaban a agosto de 2021 y Aracelis Balza Ramírez fue detenida el 19 de octubre de 2025 en su residencia por funcionarios de seguridad, horas después de participar o estar relacionada con actos por la canonización de San José Gregorio Hernández en Isnotú, Trujillo.

Junto a estos nombres, cuatro ciudadanos españoles fueron liberados. José María Basoa, vasco de 35 años, fue sacado de cautiverio donde permanecía desde su detención en Amazonas en septiembre de 2024. Andrés Martínez Adasme, otro vasco de 32 años, fue liberado junto a Basoa bajo acusaciones de espionaje que nunca fueron probadas. Miguel Moreno Dapena, marinero y periodista canario, fue excarcelado tras haber sido detenido en junio de 2025 mientras se encontraba en un buque de exploración marina con bandera panameña en aguas venezolanas. Ernesto Gorbe Cardona, valenciano de 52 años, fue liberado sin que las autoridades venezolanas jamás detallaran públicamente los cargos que supuestamente pesaban sobre él. Todos fueron deportados a España con escalas, pues no existen vuelos directos entre el aeropuerto de Maiquetía y Madrid en este momento.

Martha Cumbero, esposa de Nicmer Evans, en el salón de su hogar caraqueño a la espera de tener noticias de su liberación

J. B

400 excarcelaciones planeadas

Pero aquí es donde la narrativa oficial se quiebra. Estos ocho nombres representan apenas una fracción mínima de una realidad mucho más vasta. Según Foro Penal, la organización de derechos humanos que documenta cada detención política en Venezuela, entre 800 y 1.000 personas permanecen encarceladas por razones políticas. Alfredo Romero, presidente de Foro Penal, ha confirmado en sus publicaciones en X que la cifra de presos políticos alcanza los 811 casos documentados hasta los momentos.

Fuentes confiables hablan de un «paquete» de aproximadamente 400 excarcelaciones planeadas, lo que significaría que entre 400 y 600 personas seguirían tras las rejas. El Gobierno, aparentemente, ha optado por una estrategia de liberaciones graduales, lo que algunos analistas interpretan como un intento de evitar una «foto grupal» de presos políticos que resultaría demasiado incómoda para la narrativa que Delcy Rodríguez intenta construir.

Una «foto grupal» de presos políticos que resultaría demasiado incómoda para la narrativa que Delcy Rodríguez intenta construir

Mientras Martha espera, en las puertas de El Helicoide se ha formado una vigilia. Familias y medios se han apostado en las cercanias de este edificio espiral originalmente concebido como centro comercial en los años 1950, que se transformó con el tiempo en un centro de detención operado por el Servicio Bolivariano de Inteligencia Nacional (SEBIN), ese edificio que es sinónimo de desaparición forzada en Venezuela. Madres, esposas, hermanos, hijos. Algunos llevan carteles con nombres. Otros simplemente se sientan en el suelo, esperando. El calor caraqueño es sofocante, y la policía está presente, observando. Hay una tensión palpable en el aire, esa tensión que existe cuando la esperanza y el miedo coexisten en el mismo espacio.

Diego, un joven activista y estudiante de trabajo social, es parte de esa vigilia. Se involucró personalmente en la defensa de derechos humanos cuando su hermano, José Gregorio Pérez Maita, fue detenido la noche del 29 de julio de 2024 en Charallave. Su hermano fue liberado el año pasado, pero debe presentarse cada mes ante los tribunales. Ahora Diego continúa trabajando por la libertad de otros. «Estamos, por supuesto, a la espera, insistiendo en que el propio organismo que los tiene detenidos dé una información clara de quiénes son estas personas, y que incluso podamos verlos cuando sean excarcelados. Prometieron una gran cantidad de liberaciones, pero apenas han liberado unos pocos», expresó. Su voz refleja la frustración de alguien que ha visto cómo las promesas se convierten en migajas.

En las cárceles donde aún permanecen detenidos hay militares, políticos, estudiantes, activistas de derechos humanos y periodistas

En las cárceles donde aún permanecen detenidos hay militares, políticos, estudiantes, activistas de derechos humanos y periodistas. El Helicoide sigue siendo el centro de atención, pero hay otros lugares de cautiverio igualmente oscuros: Inof, Ramo Verde, Dirección Nacional de Inteligencia Militar (DGCIM), Tocorón, Yare.

Según Foro Penal, la mayoría de los extranjeros detenidos se encuentran en la cárcel de Rodeo Uno, ubicada a unos 50 kilómetros de Caracas. La nacionalidad de estos prisioneros es un reflejo de la alcurnia global del régimen: españoles, ucranianos, argentinos, ciudadanos de los Países Bajos, franceses, italianos, guyaneses, pakistaníes, libaneses, ecuatorianos, húngaros, polacos, peruanos, portugueses, hondureños, chilenos. Algunos poseen doble nacionalidad venezolana.

Españoles todavía encarcelados

Entre los españoles que aún permanecen detenidos, según documentación de Foro Penal, están figuras como Alejandro González, de 59 años, exmilitar y gerente aeronáutico de la petrolera estadounidense Chevron, quien se encuentra en Rodeo Uno. También permanece en esa misma cárcel Fernando Noya, de 33 años, estudiante cuyo único delito fue sumarse a grupos de resistencia. Uaiparu Guerere, empresario de 70 años que vivía en Barcelona hace años, fue capturado en 2023 cuando regresó a Venezuela para cerrar sus negocios.

Tambien permanecen otros españoles. Catalina Ramos, dirigente de Vente Venezuela, sigue encarcelada. Leticia García, de 68 años, lleva detenida desde junio sin motivo aparente. José Luis Machín Machín, de 64 años, exalcalde de Barinas y de sangre canaria, permanece en sus celdas. Miguel Álvarez, dirigente político de Primero Justicia, también está ahí. Jesús Ernesto Castillo, joven que residía en Barcelona y que se encontraba de vacaciones en Venezuela cuando fue capturado, sigue detenido. Jesús Enrique Gómez, acusado como la mayoría de conspiración.

Jorge Alayeto, el decano

Pero hay otros cuya historia es aún más larga. Jorge Alayeto, comerciante de 54 años, es el decano de los presos españoles. Fue detenido en 2017, acusado sin pruebas de conspiración. Lleva aproximadamente nueve años en cautiverio. Ángela Expósito, de 60 años, que dirigía la ONG Fundanimal y cuidaba a los perros de los presos políticos, fue capturada en 2018. María Auxiliadora Delgado, de 51 años, cayó en 2019 simplemente por ser hermana de un militar sospechoso, Karen Hernández, de 39 años, fue detenida en 2020 y condenada a 30 años por su supuesta implicación en la «Operación Gedeón».

Montserrat Espinosa, dueña de una pizzería, permanece encarcelada en La Yaguara, conglomerado policial, simplemente porque a su negocio llegó un sobre sospechoso.

Los mecanismos de la liberación revelan la naturaleza del sistema. Algunos de los excarcelados fueron sacados de El Helicoide en patrullas con vidrios ahumados y dejados luego en diferentes puntos de Caracas, como si el régimen quisiera borrar cualquier rastro de su encarcelamiento. La estrategia es clara: liberar, pero sin reconocer. Anunciar, pero sin detallar. Prometer, pero sin cumplir completamente.

La estrategia es clara: liberar, pero sin reconocer. Anunciar, pero sin detallar. Prometer, pero sin cumplir completamente

Mientras tanto, el régimen intenta proyectar normalidad. Delcy Rodríguez presidió un acto de homenaje a los «combatientes y civiles caídos durante el ataque americano contra Venezuela». Anunció la creación de un monumento en honor a quienes fueron declarados «héroes de la patria», incluyendo a 32 cubanos. Otorgó ascensos y condecoraciones. Envió mensajes al pueblo estadounidense sobre la «agresión vil y guerrerista». Reiteró que Venezuela no está «subordinada ni sometida» y que tiene «lealtad con el presidente constitucional Nicolás Maduro y con la primera combatiente Cilia Flores, quiénes han sido secuestrados».

Es el teatro de la normalidad en un país que es todo menos normal. Mientras algunos salen, otros siguen adentro. Mientras se construyen monumentos a los mártires, se mantienen en secreto los nombres de quiénes aún están en las celdas. Martha sigue esperando una llamada que quizás nunca llegue. Diego sigue en la vigilia frente a El Helicoide. Y España, desde Madrid, observa cómo sus ciudadanos permanecen en el cautiverio de una administracion que usa la represión como instrumento de control. Venezuela se ha convertido en un espejismo donde se intenta reescribir la realidad, donde la liberación de 9 personas se presenta como un acto de magnanimidad mientras cientos permanecen en la sombra, esperando.