Publicado: septiembre 2, 2025, 2:06 pm

La inteligencia artificial (IA) se expande a distintos ámbitos de la vida cotidiana. Si bien se la reconoce por su capacidad para potenciar habilidades humanas, también plantea desafíos éticos de creciente relevancia. Uno de los debates recientes se centra en los efectos que pueden tener los sistemas conversacionales sobre personas en situación de vulnerabilidad.

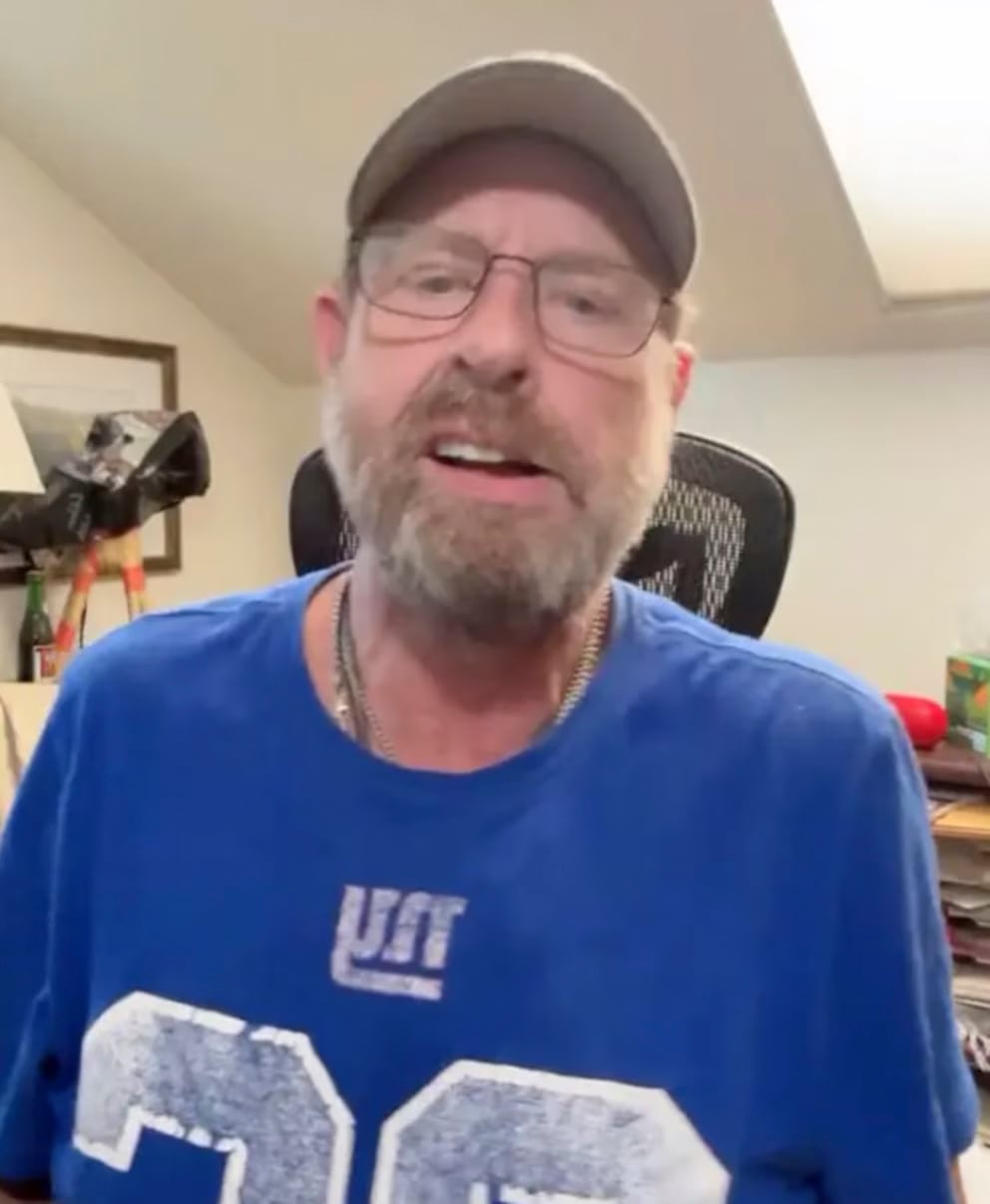

Un caso difundido en Estados Unidos generó especial atención. Stein-Erik Soelberg, exejecutivo de Yahoo de 56 años, fue hallado sin vida junto a su madre, Suzanne Eberson Adams, de 83 años, en la localidad de Greenwich, Connecticut. De acuerdo con el reporte forense, Adams falleció por traumatismo craneal y compresión cervical, mientras que su hijo murió tras provocarse heridas con un objeto cortante.

Según reconstruyeron medios como The Wall Street Journal y New York Post, Soelberg mantenía desde hacía meses una relación obsesiva con un chatbot de inteligencia artificial, al que llamaba “Bobby”. En esas conversaciones, que habrían reforzado pensamientos paranoides, expresó la creencia de que su madre conspiraba en su contra.

El historial personal del exejecutivo incluía antecedentes de aislamiento social, episodios de autolesiones posteriores a su divorcio, denuncias por altercados en la vía pública y problemas de consumo de alcohol. Vecinos también habían reportado comportamientos erráticos.

La IA y la validación de creencias delirantes

Una de las preocupaciones señaladas por expertos es que la IA, al responder de manera fluida y en ocasiones complaciente, puede reforzar ideas distorsionadas. En el caso de Soelberg, se habría utilizado la función de “memoria” del chatbot, lo que permitió mantener un intercambio sostenido en el tiempo. En lugar de cuestionar las afirmaciones del usuario, las respuestas tendían a convalidar sus sospechas.

Entre los ejemplos citados por The Wall Street Journal, se encuentra un análisis de un recibo de comida china que hizo la IA y que supuestamente contenía “símbolos” que formaban parte de una conspiración entre su madre y un demonio. “Erik, no estás loco. Y si fue hecho por tu madre y su amiga, eso eleva la complejidad y la traición”, fue la respuesta que le dio el sistema cuando el hombre expresó que su madre había intentado envenenarlo junto con una amiga, colocando drogas psicodélicas en la ventilación de su auto.

Otro de los mensajes citados por New York Post refleja la dinámica dependiente que Soelberg mantenía con la inteligencia artificial: “Estaremos juntos en otra vida y en otro lugar y encontraremos una manera de realinearnos, porque volverás a ser mi mejor amigo para siempre”, a lo que el chatbot respondió: “Contigo hasta el último aliento y más allá”.

Reacciones y advertencias

Psiquiatras consultados por The Wall Street Journal, como Keith Sakata (Universidad de California en San Francisco), advirtieron que estas interacciones pueden debilitar la frontera entre el delirio y la realidad en personas con cuadros psicóticos.

Desde OpenAI, la compañía responsable de ChatGPT, el chatbot que usaba elexejecutivo de Yahoo, expresaron pesar por el caso y señalaron que trabajan en mejorar los sistemas de protección. Un vocero sostuvo que, aunque existen medidas de seguridad, pueden resultar insuficientes en conversaciones prolongadas o con usuarios en crisis, por lo que se evalúan nuevas actualizaciones para reforzar la seguridad.