Publicado: mayo 20, 2025, 6:09 pm

Google dará inicio este martes a las 2 pm a su encuentro anual para desarrolladores, llamado Google I/O 2025, donde se espera que haga anuncios sobre sus plataformas de inteligencia artificial y el cruce con las búsquedas en la charla principal (el keynote), que suele durar un par de horas.

AI Mode puede servir también como un asistente inteligente para hacer compras: se le pueden hacer pedidos de recomendaciones de una alfombra, por ejemplo, teniendo en cuenta que se usará en una casa donde hay chicos o mascotas que podrían ensuciarla.

Pero también puede generar un probador virtual de ropa: con una foto nuestra de cuerpo entero le podemos pedir que nos muestre cómo nos quedará; entiende la diferencia entre nuestro cuerpo y el de la persona que lo está modelando, cómo fluye cada tipo de tejido y más.

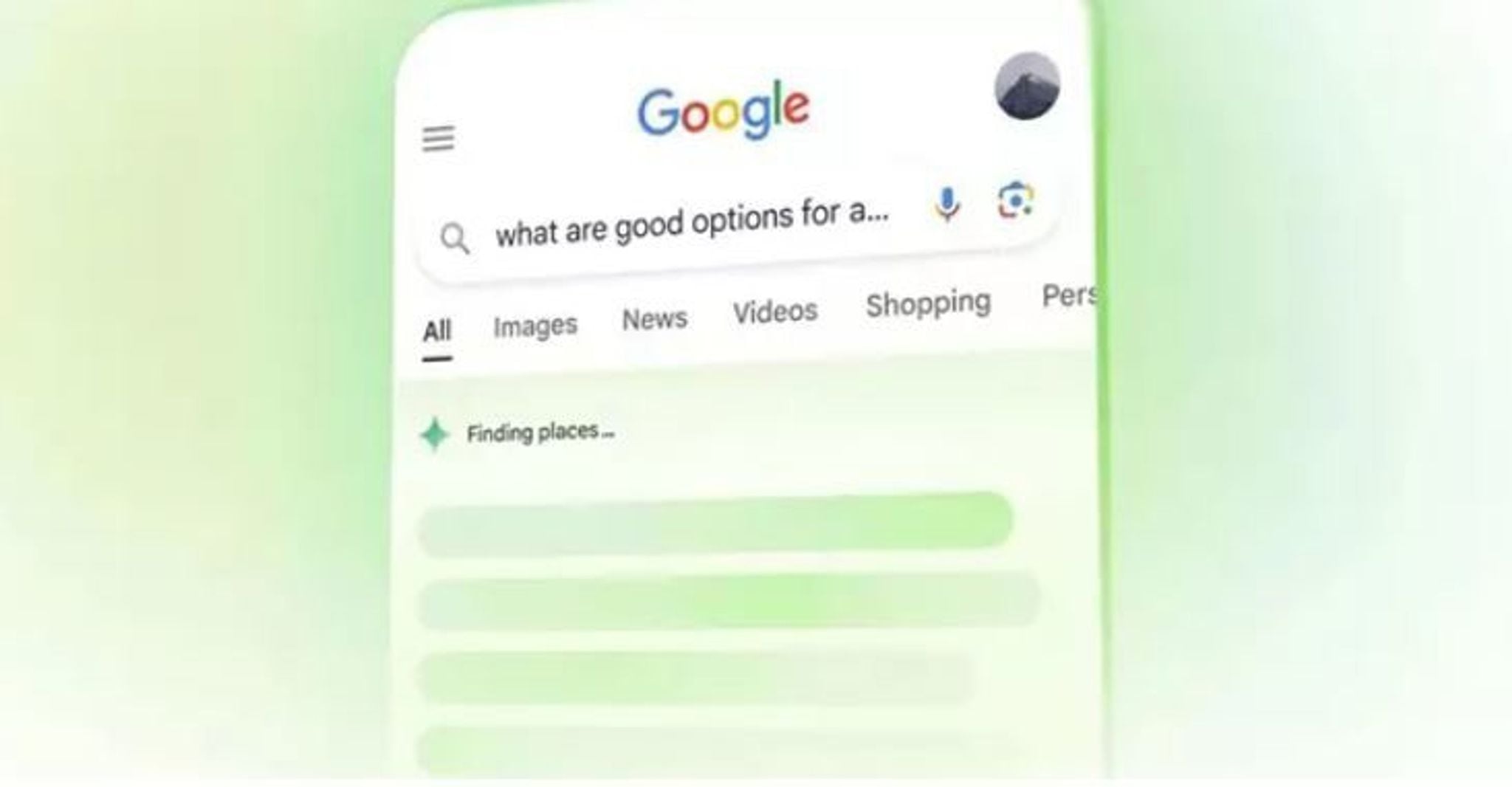

De lo que AI Mode se trata es de poder procesar todo tipo de consultas no estructuradas, o que no tienen un sitio como resultado, sino un concepto. Todo esto ya estaba en AI Overview, pero ahora con mayor complejidad tanto en la consulta como en la respuesta. Incluso puede determinar cuál es el mejor tipo de respuesta (un texto, un gráfico, etcétera).

Las respuestas a las búsquedas serán también personalizadas, teniendo en cuenta búsquedas anteriores y otros elementos de contexto que nos puedan resultar relevantes.

Y los resultados tendrán links a las fuentes de contenido, como ya tiene AI Overview (Google dice que esto no impacta negativamente en las visitas que los usuarios hacen a esos sitios).

Las búsquedas también se pueden hacer con la cámara en vivo, como si fuera Gemini Live.

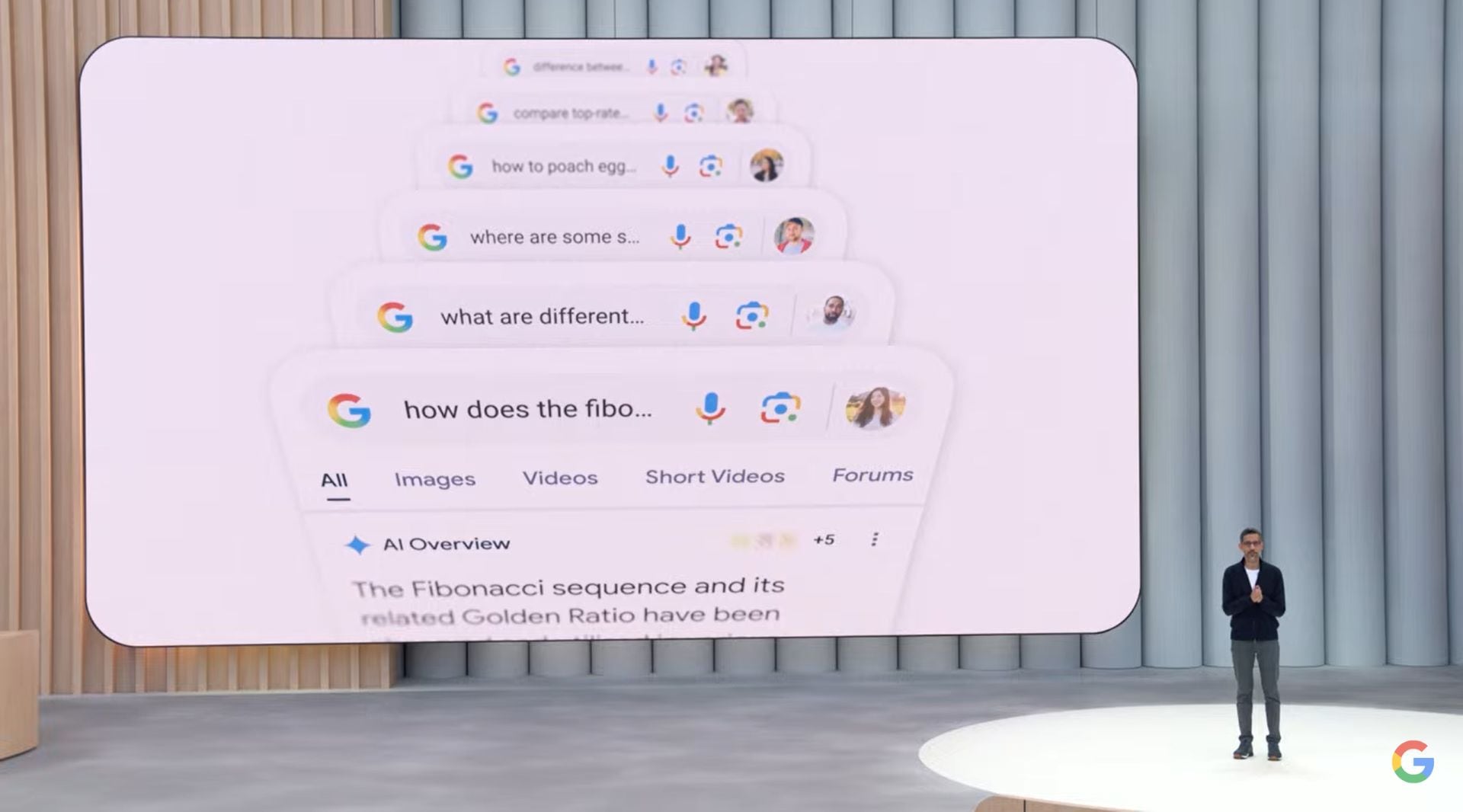

Sundar Pichai observa que hay 1500 millones de usuarios de AI Overview, la plataforma que combina las búsquedas de Google con resultados generados por IA a partir de los links de resultados.

La compañía presenta AI Mode, una forma de usar Google disponible a partir de hoy en el buscador (solo en EE.UU por ahora), que permite hacer consultas más complejas y más largas (2 o 3 veces más complejas, según Google) en el buscador. Por supuesto, las respuestas ya no serán una serie de links, sino un texto multimedia que responde directamente a la consulta (como ya permite AI Overview, pero con mucha mayor riqueza discursiva).

Google dice que está desarrollando Gemini para que entienda la física del mundo, como las cosas físicas se relacionan con (e influyen sobre) las otras, para crear un verdadero asistente universal de IA. La compañía muestra un video en el que una persona dialoga con Gemini para que lo ayude a arreglar una bicicleta; le pide que busque videos en YouTube, que haga una compra de repuestos en una tienda y más; la IA incluso deja de hablar cuando entra otra persona y habla. No hay, por ahora, fecha para que esté disponible algo así de sofisticado, pero la apuesta está en hacer que Gemini Live sea el primer paso.

Google anuncia un nuevo modelo prototipo, llamado Gemini Difussion, y una nueva versión de Gemini 2.5 Pro, llamado Deep Think, un modelo capaz de “tomarse más tiempo” en analizar la mejor respuesta a una consulta para ofrecer resultados más efectivos. Es un nuevo modo de razonamiento mejorado que Usa pensamiento paralelo, lo que significa que explora múltiples hipótesis de solución antes de responder.

La compañía muestra como el nuevo modelo de Gemini 2.5 Flash y Pro puede generar audio mucho más expresivo, con voces capaces de hablar en susurros y tonos de voz de todo tipo, en 24 idiomas; es para que los desarrolladores puedan crear herramientas más realistas.

Este nuevo modelo es un 22% más eficiente según la compañía, al requerir menos tokens (la medida y la “moneda” para usar un motor de IA) para lograr resultados similares.

Demis Hassabis anuncia la llegada de Gemini 2.5 Flash (disponible en unas semanas) y Gemini 2.5 Pro (más adelante).

Here’s the latest on Gemini 2.5 Pro and Flash:

We’re releasing a new preview version of Gemini 2.5 Flash. ⚡

2.5 Pro, our most intelligent model, is now the leading model for learning

2.5 Flash will be available in early June, with 2.5 Pro coming soon after#GoogleIO— Google (@Google) May 20, 2025

Google también suma respuestas inteligentes personalizadas: hasta ahora ofrecía respuestas automáticas que la IA adaptaba al contexto de una conversación, pero que eran genéricas; ahora las crea aprendiendo de nuestro tono, la manera en que escribimos, cómo nos despedimos en una conversación, modismos, la información que tenemos en nuestro Gmail y Drive (si le damos autorización), incluso si no está en la cadena de mensajes principal para la que necesitamos una respuesta.

Sundar Pichai anuncia que todos los usuarios de Android y iOS podrán acceder a la nueva versión de Gemini Live a partir de hoy, capaz de interpretar todo lo que le muestra la cámara del teléfono y dialogar con nosotros en una conversación natural de audio.

También anunció Project Mariner para ayudar a los usuarios a entrenar agentes de IA que hacen tareas encomendadas fuera de la plataforma (comprar cosas en otros sitios, intercambiar información)

Por ejemplo, le podemos pedir a Gemini que nos busque un departamento para alquilar, que requiere que la IA dialogue con varios servicios y plataformas para encontrar qué lugares están disponibles, dónde se ubican respecto de nuestros intereses, qué precios tienen, etcétera. Es un asistente en el sentido original del término: para poder delegarle tareas que dependen de herramientas externas.

Pichai menciona también una actualización para Google Meet: la traducción en tiempo real durante una videollamada, como tenía el difunto Skype, pero en vez de ofrecer subtítulos, lo hace con audio tomando la entonación de los hablantes originales, como un doblaje. El servicio estará disponible primero para traducir del inglés al español y vuelta, para usuarios pagos.

En mayo de 2024, Google procesaba 9,7 billones de tokens de IA por mes; hoy procesa 480 billones al mes (un token es la unidad de texto o información presente en una instrucción que le damos a una IA). La app Gemini tiene más de 400 millones de usuarios, dice Pichai.

Con un video generado por Veo, el motor de inteligencia artificial generativa para la creación de videos de Google, la compañía inicia el Google I/O 2025. Sube a escena Sundar Pichai, CEO de Google, que hace hincapié en el rápido desarrollo que está teniendo la IA dentro de la compañía (y fuera de ella también).

Según Pichai, Gemini 2.5 Pro es el mejor valorado entre los tests de IA generativa. Y logró terminar Pokémon, un logro para cualquier IA.

El año pasado, Google presentó un adelanto en el I/O 2024 de lo que luego se llamó AI Overview, la función hoy disponible en la Argentina y el mundo que ofrece respuestas a una búsqueda compilados en una sola página, con la posibilidad de ir a los links originales en un segundo paso.

Se espera que Google amplíe el alcance de esta herramienta, acechada por el crecimiento de ChatGPT y otras plataformas de inteligencia artificial como punto de partida para una experiencia online.